|

|

注册登录后全站资源免费查看下载

您需要 登录 才可以下载或查看,没有账号?立即注册

×

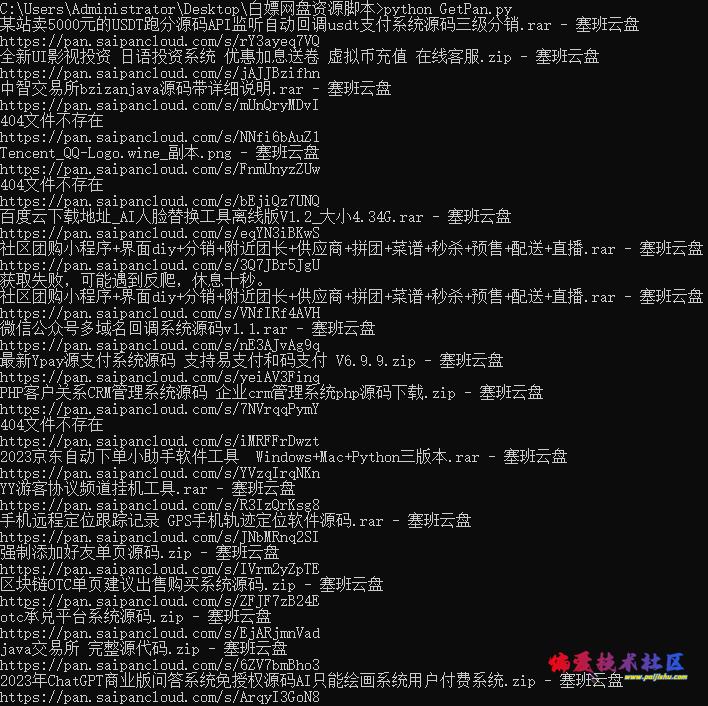

实现思路很简单,主要是找到了网盘的sitemap,再写了个python脚本实现批量获取资源内容及下载链接。

没什么技术含量,直接把代码贴出来,需要的兄弟们拿去用。

传了一份脚本到百度网盘(懒人通道,和下面的代码),有需要的回复可见下载地址。

- import time

- import requests

- from bs4 import BeautifulSoup

- import xml.etree.ElementTree as ET

- url='https://pan.saipancloud.com/sitemap.xml'

- res=requests.get(url)

- html=res.text

- with open('sitemap.xml', 'w') as f:

- f.write(html)

- tree = ET.parse('sitemap.xml')

- root = tree.getroot()

- for stu in root:

- res = requests.get(stu[0].text)

- res.encoding = 'utf-8' #

- soup = BeautifulSoup(res.text, 'lxml')

- if(soup.title):

- Title = str(soup.title.text)

- else:

- print('获取失败,可能遇到反爬,休息十秒。')

- time.sleep(12) #休息十秒防止速率过快反爬

- print(Title)

- print (stu[0].text)

- with open('Result.txt', 'a+') as j:

- j.write('标题:' + Title + '网址:' + str(stu[0].text) + "\n")

-

- time.sleep(1) #休息一秒防止速率过快反爬

|

评分

-

查看全部评分

|